1 本格的なAI時代を迎えて、人間と機械の関係はいかにあるべきか

人間の仕事と機械の仕事の境界はどこにあるのか。機械は、人間の仕事のどの領域まで組み込むのがいいのか。

例えば、今のロボットは、人間の手とほとんど同じような繊細な動きができるロボットが作られている。人間の手が生えている、という錯覚に陥るようなロボットである。

工場では、例えばとても細かい部品を取ってきて小さいものを組み立てたり、機械の裏側に人間が入り込んで組み立てるような作業は、人間でないとできないと言われてきた。

だが、こういった作業も恐らく、もうすぐロボットができるようになる。

最近では、視覚を持ち、見て、認識して、考えて結論を出すという人工知能という機械が出現してきた。人工知能は、これまでは認識をしてもその意味を理解していなかったが、2年ほど前に、猫を猫だと理解して認識することができた。

それがさらに進化すると、人工知能はあらゆるものを理解して認識することが可能になるだろう。

最後の人間の砦と言われている芸術分野も、実はよく分解して見ると、いわゆる繰り返しの部分が結構あり、繰り返しであれば必ずプログラミングできるので、そこも人工知能ができると言われている。

そうすると、最終的に、人間に残される仕事は、本当に創造的な部分や初めて実施する部分、何か突拍子もない事件が勃発し、過去に前例のない対応をする部分、などということくらいしか残らなくなる。

数十年後には、人間の社会は、そういう社会になるだろうというのがほぼ見えてきている。

そういった時代に、人間が人間らしく生きるには、人間が生きがいを持って生きるには、どうすればいいか。

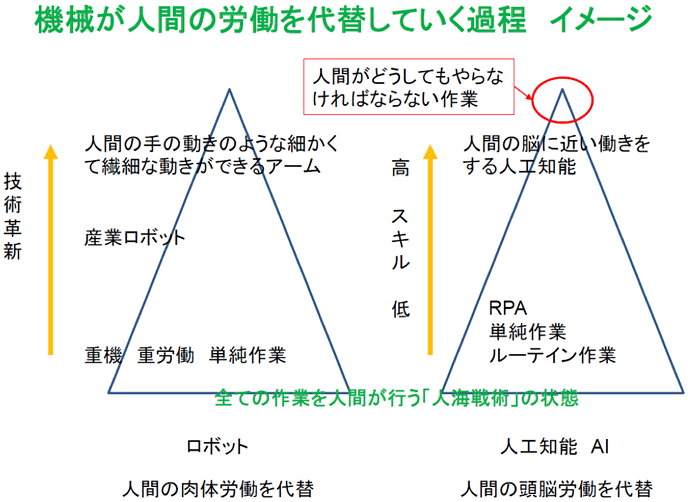

2 全ての作業を人間が行う「人海戦術」の状態から機械が担う作業と人間が担う作業への分化

これまで人間が行ってきたさまざまな作業が、機械が担う作業と、人間が担う作業に分化していく。

分化が進化すると、人間がどうしてもやらなければならない作業だけが残る。人間に求められる能力は、ますます「高いスキル」が求められるようになる。

そのため、人間は生涯にわたってスキルを磨き続けることが必要になってくる。

われわれの社会は人間中心の社会なので、機械の進歩は、人間の生活を豊かにする方向で発展しないといけない。

機械に、仕事を取られた、生きがいを取られた、ということではなく、人間が生き生きと生活できることが重要である。

生き生きと生きる、生きがいを感じる、あくまでも機械が人間をサポートする、そういう機械と人間の関係は一体どうあるべきなのだろうか。

人間の考え方や感受性を考慮し、人間がどうあるのが一番良い社会なのか。そこを考えていかないと、人工知能も、むやみやたらと技術だけ進歩すればよい、というものではない。

そういう領域に入りつつある今、人間と機械の境界はどこにあるのか、を考えないといけない。

例えば自動車という機械が世の中に出てきたが、自動車ができたことによって、人間を運んでいた仕事、すなわち籠屋の仕事はなくなった。だが、自動車の方がはるかに快適に、はるかに遠くまで、早く人を運ぶことが可能になった。これは人間の社会を豊かにしたと思う。

自動車の出現によって、人間がみすぼらしくなったということにはならないような気がする。

昔は、郵便物は、飛脚という人間が運んでいたが、これも今は機械が運ぶようになった。これも人間社会が豊かになったと考えられると思う。

昔はピラミッドも、労働者が造っていたが、今、重機が登場したので、人間が重労働をすることはなくなった。

それらの機械の出現は、人間社会を豊かにしてきた、心を豊かにしてきた、人生を楽しくしてきた、というとらえ方ができるだろう。

だが、肉体労働が生きがいの人の仕事が、完全にロボットで置き換えられたとき、本当に、それで人間は豊かになったと言えるのだろうか。

また、人間の脳の働きを機械が代替するような、本格的な人工知能の時代、頭脳労働者が、完全に人工知能で置き換えられたとき、それで人間は豊かになったと言えるのだろうか。

この問題を考える研究はHMI(Human Machine Interaction)と呼ばれ、まだ始まったばかりである。日本ではまだほとんど何も手がついていない。

3 AI自体が持つ本質的な課題

AIは、過去の情報を学習して賢くなっていく。例えば、米国マイクロソフトが2016年に公開したチャットボット「Tay(テイ)」は、公開直後に人種差別的な発言を繰り返すようになり、同社は公開を取りやめた。2015年には米国グーグルの写真共有サービス「グーグルフォト」で、AIが黒人の顔をゴリラと誤って認識してタグ付けした(注1、注2)。

労働問題に関しても、過去の労働環境を学び、それを是とし、それを前提として、判断することとなる。AIが過去の情報を学ぶことで、現在の判断に不当な差別が生じさせないためには、AIに学習させる情報を事前に選別しなければならない。

AIは、過去の延長線上でしか、考えることができない機械である。そのため、過去の延長線とは違った判断をAIに求めるのであれば、AIに対して、恣意的な操作を人間が加えないといけない。その操作内容により、AIの判断が決まってくる。

すなわち、AIが判断した、と言いながら、結局はAIに手を加えた人間の判断である。