| 執筆者 | 成田 悠輔(客員研究員)/奥村 恭平(Northwestern University)/清水 亮洋(株式会社メルカリ)/矢田 紘平(University of Wisconsin-Madison) |

|---|---|

| ダウンロード/関連リンク |

このノンテクニカルサマリーは、分析結果を踏まえつつ、政策的含意を中心に大胆に記述したもので、DP・PDPの一部分ではありません。分析内容の詳細はDP・PDP本文をお読みください。また、ここに述べられている見解は執筆者個人の責任で発表するものであり、所属する組織および(独)経済産業研究所としての見解を示すものではありません。

その他特別な研究成果(所属プロジェクトなし)

アルゴリズムによる意思決定・選択・推薦が世を覆い尽くしはじめている。動画やニュースなどのコンテンツ配信やソーシャルメディア、ECにおける広告配信はもちろんのこと、金融、裁判、監視に至るまで、アルゴリズムによる予測や分類を用いた意思決定が爆発的に広がっている。監視を例にとれば、監視カメラが捉えた画像データを画像認識し、そこに映っている人物が犯罪やテロに加担する可能性を機械学習アルゴリズムが予測する。そして、危険性が高いと予測された人物を追跡するという意思決定が行われる。

意思決定に用いられるアルゴリズムは、機械学習アルゴリズムに限らない。たとえば、世界各地の学校選択・入試制度や労働市場・臓器移植市場などではマッチングアルゴリズムが用いられている。また、国債市場・卸売市場やオンライン広告・中古品市場などでは、オークションアルゴリズムが活用されている。このようなマッチングやオークションなどの中央集権的な制度もまた、アルゴリズムを用いた意思決定である。

アルゴリズムによる意思決定を行ううえで重要なのが、まだ使われたことのない新しい意思決定アルゴリズム(方策とも呼ぶ)の性能を予測することだ。正確な性能予測があれば、着実にアルゴリズムを改善することができる。すぐに思い浮かぶ性能予測方法は、古いアルゴリズムと新しいアルゴリズムをランダムに人や地域に割り当てて比較するランダム化実験(RCT、A/Bテスト)だろう。だが、RCTは工数も費用もかかるうえ、被験者に不公平感を与えて炎上しかねないという倫理的問題を抱えている(Narita 2021)。

RCTに頼ることなく、過去のアルゴリズムが自然に生み出したデータだけで性能予測する方法はないだろうか?データに基づくアルゴリズム的意思決定が当たり前になりつつある今、既存の制度が生み出したデータに基づいてより良い制度を逐次的にデザインするデータ駆動型制度設計の手法は今後ますます重要になっていくはずだ(成田他2020、Narita and Yata 2021)。

既存の方策が生成したデータを用いて新方策の性能を推定しようとする営みは、方策外評価(off-policy evaluation; OPE)と呼ばれる。既存の方策が確率的であるとき、つまり、任意の入力に対し複数の選択肢を確率的に選ぶときについては、さまざまな方策外評価の手法が提案されてきた(Saito et al 2021a, b)。一方、既存の方策が非確率的で確定的(deterministic)である場合、つまり、ある種の入力に対しては決まった一つの選択肢を確実に選ぶときについては、確立された手法が存在していなかった。

私たちは、非確率的な方策を含む幅広いクラスの既存方策に適用可能な方策外評価の手法を提案する。この方法は以下の観察に基づく。アルゴリズムが意思決定を行った場合、そこから生成されたデータには、意思決定がランダムに、あたかもサイコロを振ったかのように行われる自然実験がほぼ必ず含まれるという観察である。たとえば、多くの確率的な強化学習・バンディットアルゴリズムは選択(探索)をランダムに行うため、ほとんどRCTそのものである。また、教師付き学習で予測された何らかの変数がある基準値を上回るかどうかで選択を決める確定的なアルゴリズムを考えた場合、基準値の近くでは、ほぼ同じ状況であるにもかかわらず、基準値をたまたま上回ったかどうかというほとんど偶然の要因で異なった意思決定が行われる。これも局所的な自然実験とみなせる。

こういった自然実験はさまざまな目的のために使える。意思決定のうちどれが効果的かを測るために使えるし、新たな意思決定アルゴリズムを導入するとどのような性能を発揮しそうかを予測するためにも使える。私たちは、この観察を一般の機械学習アルゴリズムについて定式化し、アルゴリズムが自然に生成したデータを用いてアルゴリズムを改善する手法を開発する。

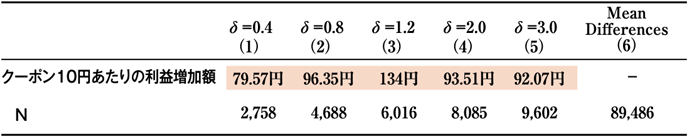

この手法が使える場面は、ビジネスから政策まで幅広い。具体的な応用として、フリマアプリ・メルカリにおけるクーポン配信方策の評価を行う。多くの企業が大量のクーポンやポイントを発行しているが、本当のところクーポン発行のコスパは良いのだろうか、悪いのだろうか?事業者が発行したクーポンをお客が利用すると、事業者はコストを被ることになる。同時に、クーポンをきっかけとした追加購買によって収益も増える。表は、クーポンコスト10円あたりの会社収益増加額を私たちの手法を使って推定したものだ。いくつかのパターンを仮定して推定を行ったが、少なくとも80円程度収益が増加していて、クーポン発行が効果的な施策であることがわかる。私たちの手法に基づくこの観察は、クーポン発行を増やすことが収益改善につながることを示唆している。

なお、本論文の技術的詳細の日本語での解説は奥村他(2022)を参照していただきたい。

- 参考文献

-

- Yusuke Narita (2021) "Incorporating Ethics and Welfare into Randomized Experiments" Proceedings of the National Academy of Sciences

- Yusuke Narita and Kohei Yata (2021) "Algorithm is Experiment: Machine Learning, Market Design, and Policy Eligibility Rules" RIETI Discussion Paper Series 21-E-057 and arXiv:2104.12909

- Yuta Saito, Shunsuke Aihara, Megumi Matsutani, Yusuke Narita (2021a) "Open Bandit Dataset and Pipeline: Towards Realistic and Reproducible Off-policy Evaluation" 35th Conference on Neural Information Processing Systems (NeurIPS 2021)

- Yuta Saito, Takuma Udagawa, Haruka Kiyohara, Kazuki Mogi, Yusuke Narita, Kei Tateno (2021b) "Evaluating the Robustness of Off-Policy Evaluation" Proceedings of the 15th ACM Conference on Recommender Systems (RecSys '21)

- 奥村恭平、清水亮洋、成田悠輔、矢田紘平(2022)「データ駆動制度設計に向けて―アルゴリズム生成データによる反実仮想予測―」オペレーションズ・リサーチ67巻3号

- 成田悠輔、粟飯原俊介、齋藤優太、松谷恵、矢田紘平(2020)「自然実験としてのアルゴリズム:機械学習・市場設計・公共政策への統一アプローチ」RIETIディスカッション・ペーパー:20-J-045