| 執筆者 | 成田 悠輔 (客員研究員)/粟飯原 俊介 (ZOZOテクノロジーズ、半熟仮想株式会社)/齋藤 優太 (東京工業大学、半熟仮想株式会社)/松谷 恵 (ZOZOテクノロジーズ)/矢田 紘平 (イェール大学) |

|---|---|

| ダウンロード/関連リンク |

このノンテクニカルサマリーは、分析結果を踏まえつつ、政策的含意を中心に大胆に記述したもので、DP・PDPの一部分ではありません。分析内容の詳細はDP・PDP本文をお読みください。また、ここに述べられている見解は執筆者個人の責任で発表するものであり、所属する組織および(独)経済産業研究所としての見解を示すものではありません。

その他特別な研究成果(所属プロジェクトなし)

機械学習アルゴリズムによる予測や分類を用いた意思決定が雨後の筍状態である。例えば、Amazon、Facebook、Google、Microsoft、Netflixをはじめとするウェブ企業は、表示するコンテンツ(映画、音楽、ニュース等)や広告の選択、価格や検索結果順位の決定といった問題に、機械学習を応用している。また、UberやLyft、DiDiといった自動車共有サービスの価格は、各時点・場所における需要と供給の情報をもとに、独自のアルゴリズムによって決定されている。

機械学習アルゴリズムを利用した意思決定は、デジタル世界以外にも広がっている。例えば裁判や保釈判決がその例だ。米国企業Northpointe(現Equivant)が開発したソフトウェアCOMPASは、教師あり機械学習を用いて被告人の再犯確率を予測する。COMPASの予測した危険指数は、米国の多くの裁判官の判断材料として実際に利用されている。その他、機械学習アルゴリズムを用いた人事採用システムも登場している。表1にこれらの例の一部をまとめた。

| アルゴリズムが用いる変数(X) | アルゴリズムの意思決定(Z) | 結果変数(Y) | アルゴリズム例 | |

|---|---|---|---|---|

| ウェブ企業 | 利用者の閲覧履歴、アクセスの時間・場所 | 表示コンテンツ | 利用者がコンテンツにアクセスしたかどうか | バンディット等の強化学習 |

| 自動車共有サービス | 利用者がアプリを開いた時点における周辺地域の需要と供給の情報 | サービスの価格 | 利用者がサービスを利用したかどうか | 価格上昇 動的価格決定 |

| 裁判官 | 被告人の犯罪歴、年齢等の属性 | 釈放すべきか否か | 被告人が再犯したかどうか | 教師あり学習 |

機械学習以外のアルゴリズムも枚挙にいとまがない。例えば、世界各地の学校選択・入試制度や労働市場・臓器移植市場などでは割当アルゴリズムが用いられている。国債市場や卸売市場からオンラインの広告や中古品市場まで、オークションアルゴリズムが用いられる場面も数多い。その他多くの公共政策領域でも、アルゴリズム的ルールを用いて受益資格が決まる場面は多い。このような市場設計や資格決定もまたアルゴリズムを用いた意思決定である(表2)。

| アルゴリズムが用いる変数(X) | アルゴリズムの意思決定(Z) | 結果変数(Y) | アルゴリズム例 | |

|---|---|---|---|---|

| 学校選択制・中央集権入試 | 家庭の学校への選好、学校での優先権 | 学校への割り当て・入学権 | 将来の成績や収入など | 受入保留アルゴリズムなどの割当アルゴリズム |

| オークション | 入札者の入札額 | 入札者が落札したか | 入札者の将来の経済パフォーマンス | オークション・アルゴリズム |

| 雇用調整助成金や持続化給付金などの資格判断 | 家庭の経済状態や家族構成 | 受益資格があるかどうか | 将来の経済・健康状態 | 受益資格決定規則 |

アルゴリズムによる意思決定を行う上で重要なのが、まだ使われたことのない新しい意思決定アルゴリズムの性能を予測することだ。正確な性能予測があれば、着実にアルゴリズムを改善することができる。すぐに思い浮かぶ性能予測方法は、古いアルゴリズムと新しいアルゴリズムをランダムにユーザーに割り当てて比較するランダム化実験(RCT, A/Bテスト)だろう。だが、RCTは工数も費用もかかる上、被験者に不公平感を与えるという倫理的問題を抱えている。RCTに頼ることなく、過去のアルゴリズムが自然に生み出したデータだけで性能予測する方法はないだろうか?

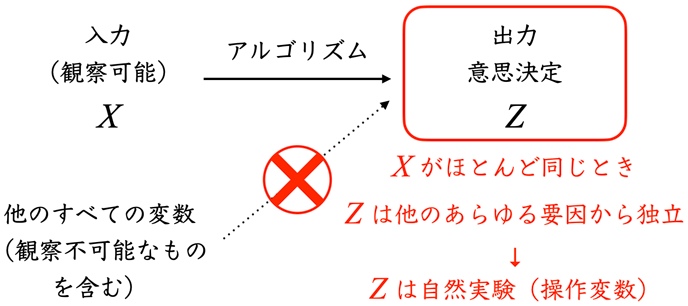

私たちは、過去のアルゴリズムが蓄積したデータを用いて、別の新たなアルゴリズムの評価を行う方法を提案する。この方法は以下の観察に基づく(図1)。アルゴリズムを利用して意思決定が行われた場合、そこから生成されたデータには、意思決定がランダムに、あたかもサイコロを振ったかのように行われる自然実験がほぼ必ず含まれるという観察である。例えば、多くの確率的な強化学習・バンディットアルゴリズムは選択(探索)をランダムに行うため、ほとんどRCTそのものである。

また、教師付き学習で予測された何らかの変数がある基準値を上回るかどうかで選択を決めるアルゴリズムを考える。この場合、基準値の近くでは、ほぼ同じ状況であるにも関わらず、基準値をたまたま上回ったかどうかというほとんど偶然の要因で異なった意思決定が行われる。これも局所的な自然実験とみなせる。

こういった自然実験はさまざまな目的のために使える。意思決定のうちどれが効果的か測るために使えるし、新たな意思決定アルゴリズムを導入するとどのような性能を発揮しそうか予測するためにも使える。私たちは、この観察を一般のアルゴリズムについて定式化し、アルゴリズムが自然に生成したデータを用いてアルゴリズムを改善する手法を開発する。

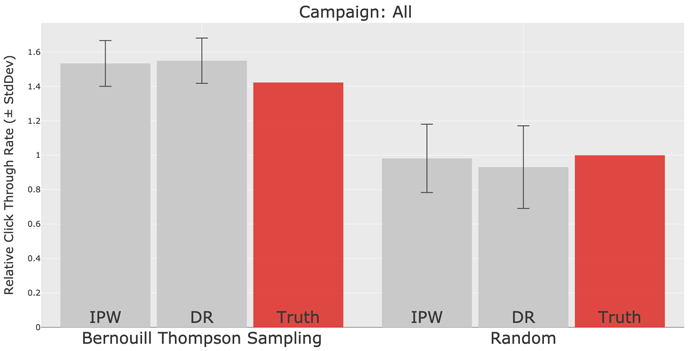

この手法が使える場面は、ビジネスから政策まで幅広い。具体的な応用として、私たち自身が行ったファッションECサービスZOZOTOWN上での実戦配備を紹介する。この応用では、ZOZOTOWNの一部でのファッション推薦のクリック率を約40%高め、さらなる改善の方法を見つけることにも成功した(図2-3)。この実装で用いた数千万件のファッション推薦データとコードはオープンソースでGitHub上で公開中だ(図4)。

今後は、今はウェブ産業に集中しているデータとアルゴリズムの価値をより広い社会に還流したい。そのビジョンに向け、同じ技術を用いて様々な政策領域の評価・設計・予測も行えるという未来展望を与える。